隨著2023年11月第二周多家人工智慧(Artificial Intelligence,AI)公司宣布版本升級,包括Google Gemini、ChatGPT4 Turbo及xAI PromptIDE等企業, AI的應用範疇更為擴大,提供更強大的文字、圖形及分析能力,以滿足不同產業的需求。然而,AI快速導入產業的發展趨勢,也加劇了敵對國家或黑帽駭客組織利用AI技術進行攻擊的可能性,故須重新審視資安防禦的縱深模式。

AI科技加速產業智慧化卻帶來新的資安挑戰

產業應用的AI市場有多大,黑帽駭客組織的獲利就水漲船高,因為當產業導入AI科技時,將提高數位化程度,使用更多的數位設備,連接應用程式介面(Application Programming Interface, API),以蒐集數位資料,導入不同的AI模型,加速產業智慧化,卻也產生新的漏洞及駭侵風險,使得資安防守的範圍正在加寬及深化,防守更加不易。

舉例來說,調查機構MMR指出:2022年國防及航空領域的AI和機器人市場規模達到189.7億美元,至2029年將達到346億美元,預測複合年增長率為7.8%,凸顯國防及航空領域導入AI科技將加速。但就在此時(2023年10月31日),波音公司卻傳出遭駭客組織使用勒索軟體LockBit進行攻擊,並可能取得公司內部敏感資料,突顯了數位導入速度變快,AI科技導入越廣,亦帶來新型資安挑戰。

因此,資安防禦體系將因為AI發展,而面臨更高的攻擊風險;因為敵對國家或黑帽駭客組織利用AI技術進行漏洞挖掘、自動化掃描及潛藏式攻擊,使得病毒擴散速度更快,自動化攻擊變強,甚至用於恐怖攻擊,突破組織所建構的實體與虛擬(資安) 縱深防禦體系,故資安防禦如何善用AI技術將成關鍵,而資安治理面將變得更為重要。

AI被濫用於恐怖攻擊的風險

早在2019年哈佛大學Marcus教授撰文AI攻擊一文,就警告恐怖組織可能利用AI科技進行攻擊,提高國家及社會的破壞性,包含:

1. 輸入型攻擊:透過操控AI輸入內容,改變輸出,破壞原目的,而進行攻擊。

2. 中毒型攻擊:破壞AI執行程序,或修改演算法,或汙染資料,影響學習程序,干預目標任務。

3. 損害型攻擊:干預AI系統,造成實質性破壞,例如干擾自動號誌系統、駭侵自駕車系統等,以破壞智慧交通系統。

4. 社交型攻擊:破壞社群的AI過濾系統,發布假訊息、錯誤安全告警及讓人民對AI系統或政府失去信心等作法。

5. 恐怖分子將使用AI武器進行攻擊,包含虛擬網路癱瘓及實體破壞:

(1) 攻擊AI演算法

(2) 利用AI漏洞進行大規模破壞

(3) AI型勒索病毒癱瘓關鍵基礎設施

(4) 恐怖無人機、蜂群無人機

(5) 自動駕駛汽車的炸彈攻擊

(6) 小型精準暗殺AI武器

(7) AI聊天機器人進行恐怖煽動

AI應用於資安攻擊

未來,國家駭客組織或黑帽駭客組織將更為廣泛的使用AI科技進行資安攻擊,於學術研究面向亦受重視,例如Sangwan et al.(2023)指出,與人工智慧相關的英文期刊文獻已有1,366篇,其中415篇研究網路攻擊對資安防禦的弱點及機制,強調AI導入階段的攻擊模式,區分為四種主要攻擊風險,重點如下:

1. 模型建構攻擊:演算法攻擊,包含漏洞、入侵、操縱特徵及模型等。

2. 訓練資料階段:容易受到未授權變更、注入或操縱資料或特徵(參數)的攻擊,如資料庫感染惡意程式,或者傳統的DDoS阻斷聯邦式學習模式,需要防禦及驗證(完整性)機制,例如資料防止中毒(或注入)機制、對抗式模型、特徵擠壓(減少特徵或參數)、阻止參數未授權變更(轉移)等。

3. 推論或測試階段:人工智慧系統可能會因將偽造的資料歸類為合法資料,而受到操縱攻擊,可使用模型的特徵向量或資料,進行模型反證或重建。

4. AI應用於資安攻擊與防禦方法:

(1) 下一代惡意軟體(程式)

(2) 無效化縱深防禦(AI多面向攻擊,使縱深防禦的無效化)

(3) 基於密碼的攻擊

(4) 社交機器人(釣魚與認知作戰?)

(5) 對抗性訓練(或學習)

(6) AI/ML系統的意外失靈(故障或效能下降)

AI發展促使資安縱深防禦模式的轉變

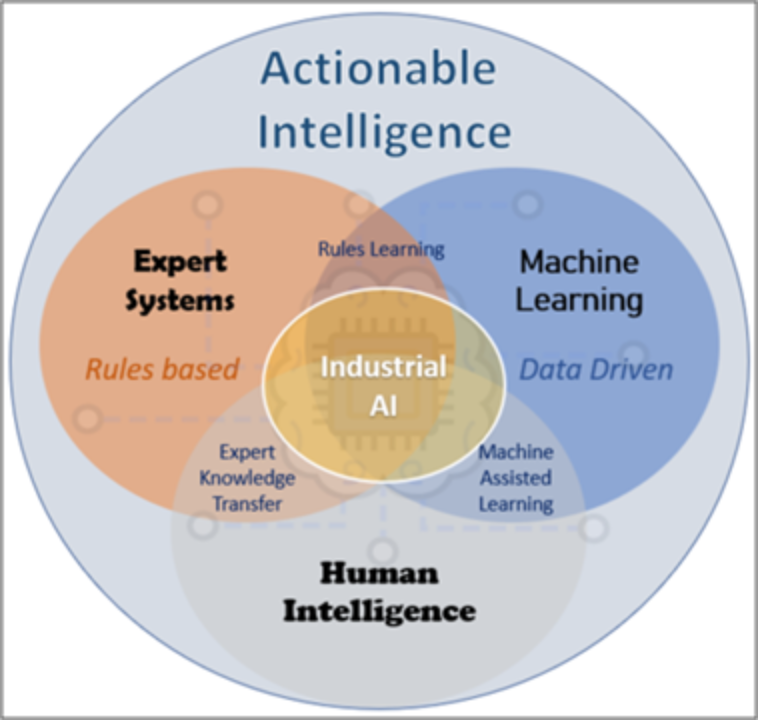

隨著2022年10月美國白宮科技政策辦公室(OSTP)發布AI權利法案藍圖(Blueprint for an AI Bill of Rights),強調AI安全有效的系統(Safe and Effective Systems)、保護和避免演算歧視(Algorithmic Discrimination Protections)、資訊隱私(Data Privacy)的保護級AI通知和解釋(Notice and Explanation)義務,強調各界導入AI科技時,須搭配資安治理機制;就此,當年同月商務部所轄國家標準暨技術研究院(National Institute of Standards and Technology, NIST)也發布工業人工智慧的管理及量化(Industrial Artificial Intelligence Management and Metrology,IAIMM)評量工具,針對專家系統、機器學習(Machine Learning)及人類智慧(詳見圖1),所建構模擬與監控AI製程,分析人力與機器的資料,以控管AI的潛在風險:

1. 驗證和評估AI/ML工具和方法

2. 風險基礎的測試方法,監控AI工具對於生產的影響

3. 製造業整合不同或異質來源的相關資料,並使用AI/ML工具須要有以下評估:

4. 非結構化資料處理和評估

5. 硬/軟感測器數據融合

6. 人機通訊(人機循環學習)

7. 非同步資料和工具

8. 資料管理、來源和利用

9. 演算法測試、資料生成和開發程序的測試平台

10. 蒐集使用AI的利害關係人資料

資料來源:https://www.nist.gov/programs-projects/industrial-artificial-intelligence-management-and-metrology-iaimm

隔(2023)年1月NIST發布AI風險框架(Artificial Intelligence Risk Management Framework, NIST AI 100-1 );同年6月14日歐洲議會表決通過「歐盟人工智慧法案」(E.U. AI Act),將AI科技分三級管理,若遭評為不可接受之風險之AI技術及應用,將完全禁止進入歐盟市場,且提出AI遭惡意濫用的風險評估機制,包括針對利用AI進行網路竊聽、中間人攻擊、物理攻擊、有毒資料注入、演算法攻擊、非故意毀損、中斷服務(或效能下降)及AI的恐怖攻擊(如自駕車炸彈)等方面進行研究,強調AI科技須要進行完整的資安風險的評估機制。

其中,前述NIST所提出的AI風險管理框架,是評估三個受駭面向建構而成,包含人(People)、組織(Organization)及生態系統(Ecosystem)的侵駭(詳見下圖2),而採取可歸責性的資安3M管理體系,分別針對AI的開發、測試、認證及稽核須要有風險管理及治理機制。

圖片來源:作者提供

產業導入AI科技,須搭配資安治理

隨著AI技術在產業中的不斷普及,資安防禦策略勢必面臨更大的挑戰,美歐等國也紛紛提出相關的法規及政策。

就此,我國行政院於2023年8月31日發布通過「行政院及所屬機關(構)使用生成式AI參考指引(草案)」,宣示製作機密文件不得用生成式AI,且強調AI基本法的立法就是先指引後立法,而立法的框架也聚焦於七大面向,包含AI法律名詞定義、隱私保護、資料治理、AI風險管控、AI倫理原則規範、產業推動,以及AI應用的遵法與合法性等。 在此建議AI基本法(草案)立法過程,須導入AI的資安治理概念,即將傳統的CIA(Confidentiality(保密性)、Integrity(完整性)、Availability(可用性)),轉變為CPR(Confidentiality(保密性)、Privacy(隱私性)及Robustness(穩健性))的概念,以學習歐盟成立獨立風險審查機制,及引入美國的產業的AI風險管理框架,及相關量化分析工具,建構AI的資安治理配套機制,降低產業導入AI的各種風險,提高AI應用的穩健性。

此文章與信傳媒同步刊登

作者為台灣駭客協會理事,中研院資訊所博士後研究人員,東吳大學科研所兼任助理教授,元智大學資管系兼任助理教授。

- 個人資料外洩的因應策略 - 2024 年 4 月 1 日

- 假新聞防治之道 - 2024 年 2 月 19 日

- 全球AI法規熱潮:歐盟領先、美國競追、台灣籌備中 - 2023 年 12 月 25 日